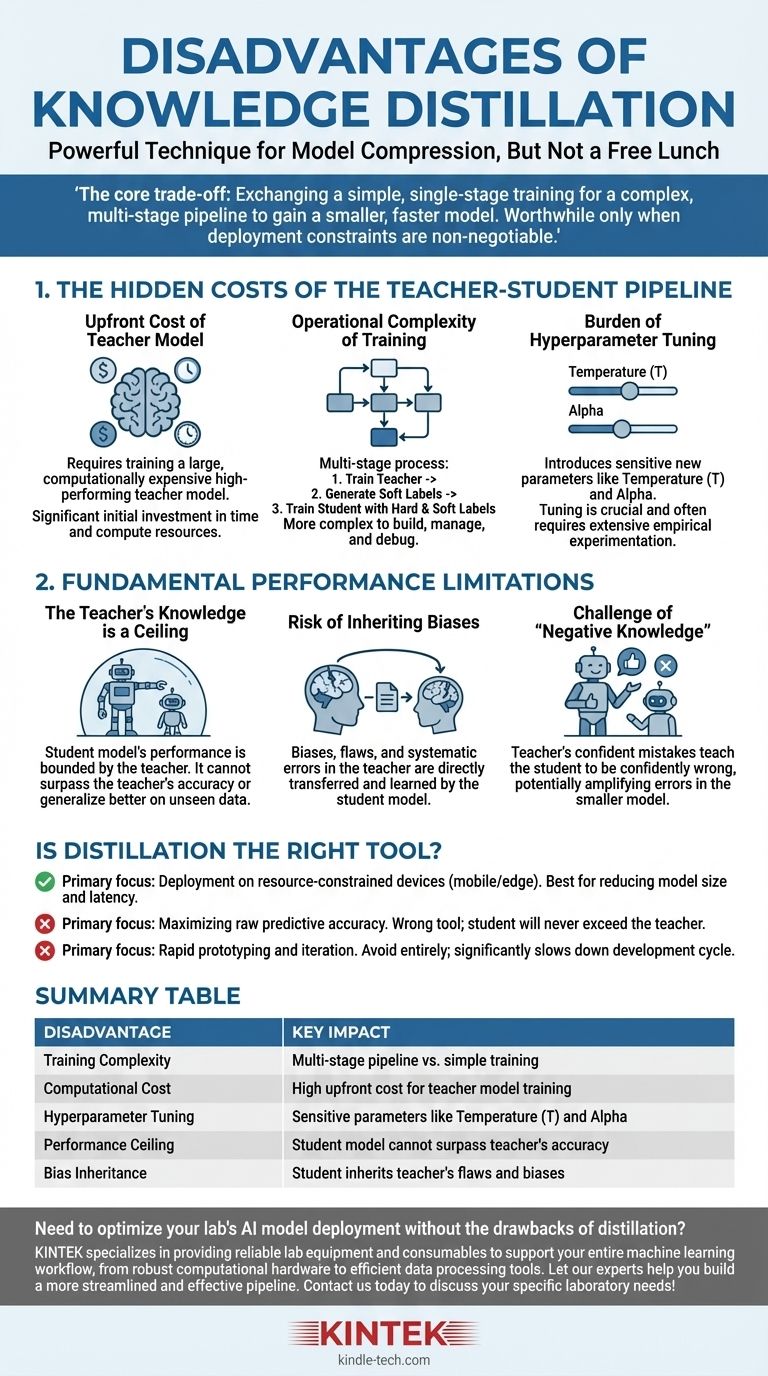

Sebbene la distillazione della conoscenza sia una tecnica potente per la compressione dei modelli, non è un pasto gratis. Gli svantaggi principali sono il significativo aumento della complessità di addestramento e dei costi computazionali, l'introduzione di nuovi iperparametri sensibili e il tetto massimo di prestazioni imposto dalla qualità del modello insegnante (teacher).

Il compromesso fondamentale della distillazione è chiaro: si scambia un processo di addestramento semplice e a stadio unico per una pipeline complessa a più stadi per ottenere un modello più piccolo e veloce. Questo investimento in complessità è utile solo quando i vincoli di implementazione, come la latenza o la memoria, sono inderogabili.

I costi nascosti della pipeline Insegnante-Studente

Gli svantaggi più immediati della distillazione non sono concettuali, ma pratici. Coinvolgono il tempo aggiuntivo, le risorse e lo sforzo ingegneristico necessari per gestire un flusso di lavoro di addestramento più complesso.

Il costo iniziale del modello insegnante

Prima ancora di poter iniziare la distillazione, è necessario un modello insegnante ad alte prestazioni. Questo modello è, per progettazione, grande e computazionalmente costoso da addestrare.

Questa fase iniziale di addestramento rappresenta un costo significativo e non banale sia in termini di tempo che di risorse di calcolo che devono essere sostenuti prima che possa iniziare l'addestramento "reale" del modello studente.

La complessità operativa dell'addestramento

La distillazione è un processo a più stadi, a differenza dell'addestramento standard del modello. Il flusso di lavoro tipico è:

- Addestrare il grande modello insegnante fino alla convergenza.

- Eseguire l'inferenza con il modello insegnante sull'intero set di dati di addestramento per generare le "etichette morbide" (soft labels) o i logit.

- Addestrare il modello studente più piccolo utilizzando sia le "etichette dure" (hard labels) originali sia le etichette morbide dell'insegnante.

Questa pipeline è intrinsecamente più complessa da costruire, gestire e sottoporre a debug rispetto a uno script di addestramento standard.

L'onere della messa a punto degli iperparametri

La distillazione introduce iperparametri unici che governano il processo di trasferimento della conoscenza e richiedono un'attenta messa a punto.

Il più critico è la temperatura (T), un valore utilizzato per ammorbidire la distribuzione di probabilità degli output dell'insegnante. Una temperatura più alta rivela informazioni più sfumate sul "ragionamento" dell'insegnante, ma trovare il valore ottimale è un processo empirico.

Un altro iperparametro chiave è alpha, che bilancia la perdita derivante dalle etichette morbide dell'insegnante rispetto alla perdita derivante dalle etichette dure (ground-truth). Questo equilibrio è cruciale per il successo e spesso richiede una sperimentazione approfondita.

I limiti fondamentali delle prestazioni

Oltre ai costi pratici, la distillazione presenta limitazioni intrinseche che limitano il potenziale del modello studente finale.

La conoscenza dell'insegnante è un tetto massimo

Le prestazioni di un modello studente sono fondamentalmente limitate dalla conoscenza del suo insegnante. Lo studente impara a imitare la distribuzione di output dell'insegnante.

Pertanto, lo studente non può superare l'insegnante in accuratezza né generalizzare meglio su dati non visti. Può solo sperare di diventare un'approssimazione altamente efficiente delle capacità dell'insegnante.

Il rischio di ereditare i bias

Qualsiasi bias, difetto o errore sistematico presente nel modello insegnante verrà direttamente trasferito e appreso dal modello studente.

La distillazione non "pulisce" la conoscenza; la trasferisce semplicemente. Se l'insegnante ha un pregiudizio contro una certa demografia o una debolezza in uno specifico dominio di dati, lo studente erediterà esattamente la stessa debolezza.

La sfida della "conoscenza negativa"

Se il modello insegnante è fiducioso ma sbagliato su una specifica previsione, insegnerà allo studente ad essere fiducioso ma sbagliato allo stesso modo.

Questo è potenzialmente più dannoso di un modello che è semplicemente incerto. Il processo di distillazione può amplificare gli errori dell'insegnante, incorporandoli nel modello più piccolo e più efficiente dove potrebbero essere più difficili da rilevare.

La distillazione è lo strumento giusto per il tuo obiettivo?

In definitiva, la decisione di utilizzare la distillazione dipende interamente dall'obiettivo primario del tuo progetto.

- Se il tuo obiettivo principale è l'implementazione su ambienti con risorse limitate (come dispositivi mobili o edge): La distillazione è una tecnica leader per ottenere la necessaria riduzione delle dimensioni del modello e della latenza, supponendo che tu possa permetterti la complessità iniziale dell'addestramento.

- Se il tuo obiettivo principale è massimizzare la precisione predittiva grezza: La distillazione è lo strumento sbagliato. Il tuo sforzo è meglio speso nell'addestrare il miglior modello autonomo possibile, poiché lo studente non supererà mai le prestazioni dell'insegnante.

- Se il tuo obiettivo principale è la prototipazione rapida e l'iterazione: Evita del tutto la distillazione. La pipeline a più stadi e la complessa messa a punto degli iperparametri rallenteranno significativamente il tuo ciclo di sviluppo e sperimentazione.

Comprendere questi svantaggi ti consente di implementare la distillazione della conoscenza strategicamente, riconoscendola come uno strumento specializzato per l'ottimizzazione, non come un metodo universale per il miglioramento.

Tabella riassuntiva:

| Svantaggio | Impatto chiave |

|---|---|

| Complessità di addestramento | Pipeline a più stadi rispetto all'addestramento semplice |

| Costo computazionale | Costo iniziale elevato per l'addestramento del modello insegnante |

| Messa a punto degli iperparametri | Parametri sensibili come temperatura (T) e alpha |

| Tetto massimo di prestazioni | Il modello studente non può superare l'accuratezza dell'insegnante |

| Ereditarietà dei bias | Lo studente eredita i difetti e i bias dell'insegnante |

Hai bisogno di ottimizzare il deployment del modello AI del tuo laboratorio senza gli svantaggi della distillazione? KINTEK è specializzata nel fornire attrezzature e materiali di consumo affidabili per supportare l'intero flusso di lavoro di machine learning, dall'hardware computazionale robusto agli strumenti efficienti per l'elaborazione dei dati. Lascia che i nostri esperti ti aiutino a costruire una pipeline più snella ed efficace. Contattaci oggi per discutere le tue esigenze specifiche di laboratorio!

Guida Visiva

Prodotti correlati

Domande frequenti

- Quali sono gli usi della sinterizzazione? Sblocca la produzione per materiali ad alta temperatura

- Perché la sorgente di sputtering a magnetron viene raffreddata durante la deposizione? Essenziale per la Stabilità del Processo e la Protezione dell'Attrezzatura

- Le pellicole sottili sono utilizzate come rivestimenti sulle lenti? La chiave per prestazioni ottiche superiori

- Perché è necessario un sistema di riscaldamento ad alta precisione per il trattamento termico dei fanghi anaerobici? Massimizzare la resa di Bio-H2

- Cos'è la deposizione di rivestimenti? Progetta Proprietà Superficiali Superiori per i Tuoi Materiali

- Quale temperatura dovrebbe avere il Rotavapor? Padroneggia la Regola Delta 20 per una Rimozione del Solvente Sicura ed Efficiente

- Cosa posso usare al posto di un bagno d'acqua in biologia? Scopri alternative più pulite e precise

- La pirolisi è dannosa per l'ambiente? Una guida per massimizzare i benefici e minimizzare i rischi